Gemma 2 sætter en ny standard med sin klasseledende ydeevne, lynhurtige hastighed på tværs af forskellige hardwareplatforme og problemfri integration med andre AI-værktøjer.

Google introducerede tidligere på året Gemma-familien af lette, avancerede open source-modeller, der bygger på den samme forskning og teknologi, som bruges til at skabe Gemini-modellerne. Gemma-familien er siden vokset med CodeGemma, RecurrentGemma og PaliGemma, der hver især tilbyder unikke egenskaber til forskellige AI-opgaver og er let tilgængelige gennem integrationer med partnere som Hugging Face, NVIDIA og Ollama.

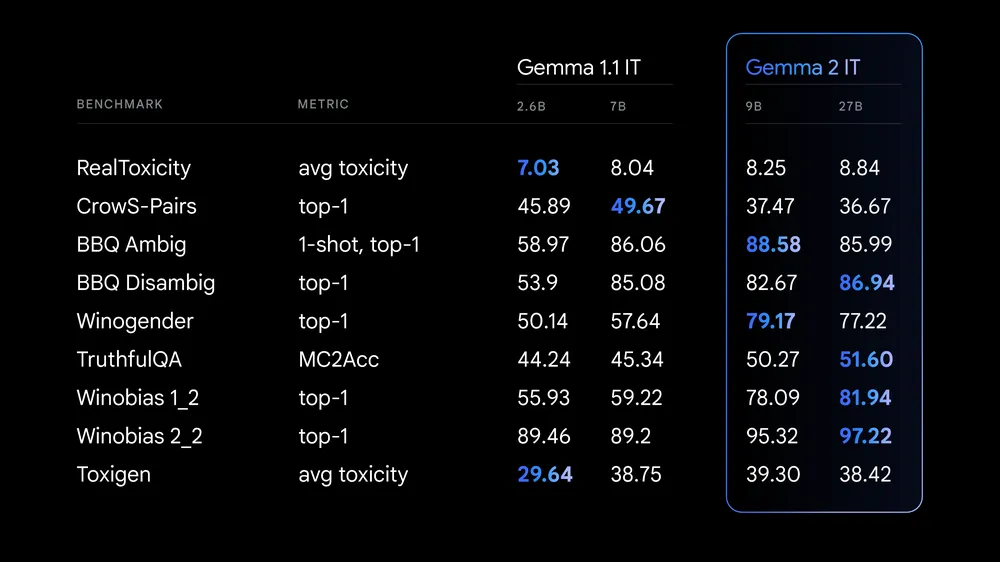

Nu udgiver Google officielt Gemma 2 til forskere og udviklere globalt. Vi burde modtage denne i denne uge. Gemma 2 er tilgængelig i både 9 milliarder (9B) og 27 milliarder (27B) parameterstørrelser og er mere effektiv end den første generation, med betydelige sikkerhedsforbedringer indbygget.

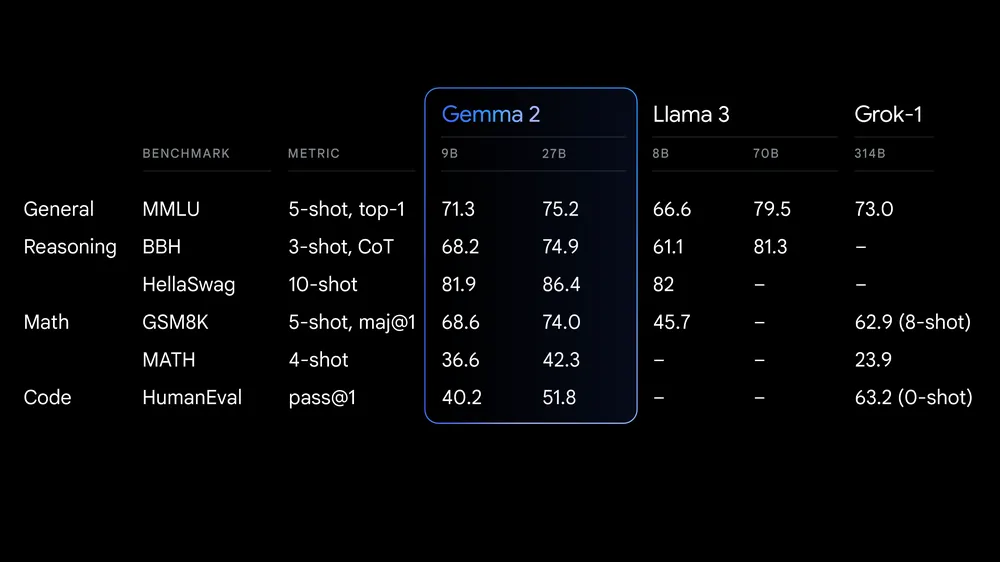

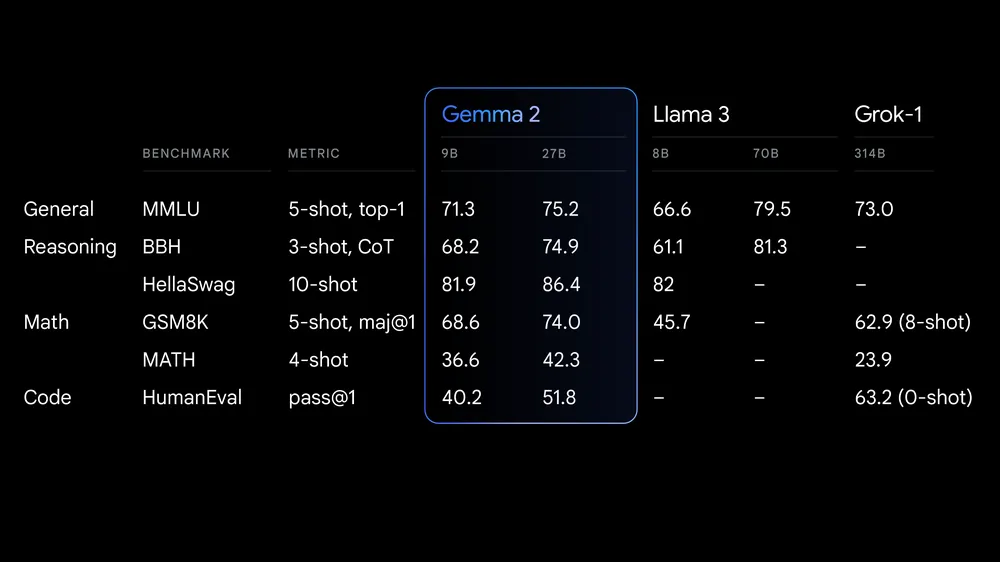

Faktisk tilbyder 27B-modellen konkurrencedygtige alternativer til modeller, der er mere end dobbelt så store, og leverer den slags ydeevne, der indtil for nylig kun var mulig med proprietære modeller. Og det er nu muligt på en enkelt NVIDIA H100 Tensor Core GPU eller TPU-vært, hvilket reducerer implementeringsomkostningerne betydeligt.

En ny åben modelstandard for effektivitet og ydeevne

Google har bygget Gemma 2 på en nydesignet arkitektur, der er konstrueret til både exceptionel ydeevne og inferenseffektivitet. Her er, hvad der gør den unik:

- Overlegen ydeevne: 27B-modellen leverer den bedste ydeevne i sin størrelsesklasse og tilbyder endda konkurrencedygtige alternativer til modeller, der er mere end dobbelt så store. 9B-modellen leverer også klasseledende ydeevne og overgår Llama 3 8B og andre åbne modeller i sin størrelseskategori. Se den tekniske rapport for detaljerede ydeevneoplysninger.

- Uovertruffen effektivitet og omkostningsbesparelser: 27B-modellen er designet til at køre inferens effektivt ved fuld præcision på en enkelt Google Cloud TPU-vært, NVIDIA A100 80GB Tensor Core GPU eller NVIDIA H100 Tensor Core GPU, hvilket reducerer omkostningerne betydeligt, samtidig med at den høje ydeevne opretholdes.

- Lynhurtig inferens på tværs af hardware: Gemma 2 er optimeret til at køre med utrolig hastighed på tværs af en række hardwareplatforme, fra kraftfulde gaming-laptops og high-end desktops til cloud-baserede opsætninger. Prøv Gemma 2 ved fuld præcision i Google AI Studio, lås op for lokal ydeevne med den kvantiserede version med Gemma.cpp på din CPU, eller prøv den på din hjemmecomputer med en NVIDIA RTX eller GeForce RTX via Hugging Face Transformers.

Bygget til udviklere og forskere

Gemma 2 er ikke kun mere kraftfuld, den er også designet til at integrere lettere i dine arbejdsgange:

- Åben og tilgængelig: Ligesom de originale Gemma-modeller er Gemma 2 tilgængelig under Googles kommercielt venlige Gemma-licens, hvilket giver udviklere og forskere mulighed for at dele og kommercialisere deres innovationer.

- Bred rammekompatibilitet: Brug Gemma 2 nemt med dine foretrukne værktøjer og arbejdsgange takket være dens kompatibilitet med større AI-rammer som Hugging Face Transformers, og JAX, PyTorch og TensorFlow via native Keras 3.0, vLLM, Gemma.cpp, Llama.cpp og Ollama. Derudover er Gemma optimeret med NVIDIA TensorRT-LLM til at køre på NVIDIA-accelereret infrastruktur eller som en NVIDIA NIM inferensmikroservice, med optimering til NVIDIAs NeMo på vej.

- Problemfri implementering: Google Cloud-kunder vil nemt kunne implementere og administrere Gemma 2 på Vertex AI.

Udforsk den nye Gemma Cookbook, en samling af praktiske eksempler og opskrifter, der guider dig gennem opbygningen af dine egne applikationer og finjustering af Gemma 2-modeller til specifikke opgaver. Opdag, hvordan du nemt bruger Gemma med dit foretrukne værktøj, herunder til almindelige opgaver som retrieval-augmented generation.

Her er en video der fortæller om hvordan sprog og kultur kan tilpasses moderne AI sprogmodeller:

Kilde: Agiludvikling A/S og Google

Fotokredit og Videokredit: Google (C) 2024

Firmaer/Navne/#: #Google #Gemma2 #AI #OpenSource #Maskinlæring #DeepLearning #Udviklere #Forskere #Innovation #Teknologi

(C) Copyright 2024: Agil Udvikling A/S